In de auto onderweg valt het op hoeveel mensen achter het stuur onverstandig omgaan met informatietechnologie (zoals met hun smartphone). Ze maken kleine foutjes: afdwalen van de rijbaan of met een schrikreactie remmen. Informatietechnologie verleidt bestuurders in hun auto om onbewust risico’s te nemen en zichzelf, inzittenden en medeweggebruikers in gevaar te brengen. Is het dan vanzelfsprekend dat diezelfde bestuurders op hun werk wel verstandig omgaan met IT en de risico’s die daarmee gepaard gaan?

Ik denk van niet. Ik denk dat mensen op hun werk ook kleine beslissingsfoutjes kunnen maken – juist met IT, net als in de auto. Met risico’s voor zichzelf, voor de organisatie en soms zelfs voor de maatschappij. Ik gebruik deze vergelijking tussen auto en werk om het onderwerp van mijn leerstoel uit te leggen.

Risicogedrag en IT: anekdotes uit het verkeer

Wie een auto ziet slingeren, denkt wellicht eerst: ‘Daar heb je weer zo iemand!’, of: ‘Die kan niet autorijden!’ Toch lijkt dit niet helemaal aan de rijkwaliteiten van de chauffeur te liggen. Daarom stel ik de lezer de concrete vraag: ‘Denkt u dat u beter of slechter auto- rijdt dan degene die nu naast u zit?’ Neem enkele seconden de tijd voor het beantwoorden van deze vraag.

Het interessante is dat uit empirisch onderzoek blijkt dat ongeveer 80 procent van de mensen vindt dat zij zelf een betere chauffeur zijn dan ‘de ander’. In uw specifieke geval kan dat natuurlijk kloppen. Maar toch is het raar dat statistisch gezien de meeste mensen zichzelf een betere chauffeur vinden dan het gemiddelde van hun collegachauffeurs. Dat kan statistisch namelijk niet. Wij zijn blijkbaar geneigd om onze eigen capaciteiten te overschatten of die van anderen te onderschatten. Dit blijft uiteraard niet per se beperkt tot het verkeer, maar is een fenomeen dat in de dagelijkse omgang en dus ook in organisaties op de loer ligt. Zo’n menselijk inschattingsfoutje is dus interessant voor onderzoek naar risicogedrag in organisaties.

Ik zal het volgende voorbeeld op mijzelf betrekken. In dit voorbeeld voeg ik informatietechnologie (IT) toe en hoe dat ons risicogedrag beïnvloedt. Onze auto is nogal onoverzichtelijk, maar heeft gelukkig voor en achter parkeersensoren: vijf lampjes laten de afstand tot een obstakel zien. Een scherp piepsignaal wordt gegeven als deze afstand te klein wordt. U kent waarschijnlijk het gemak van zulke sensoren. Ik was er blij mee, totdat ik op een donkere regenachtige zondagavond mijn auto moest keren en achteruitreed – gehaast en chagrijnig omdat mijn voetbalclub had verloren. Ik hoorde een hard krakend geluid, ik had ‘iets’ geraakt.

Niet alleen mijn club maar ook mijn parkeersensoren hebben mij vandaag in steek gelaten, dacht ik nog. Ik wist zeker dat het veiligheidssysteem was ‘vergeten’ mij een waarschuwingspiep te geven. Ook de lampjes had ik merkwaardig genoeg niet zien oplichten. Nog merkwaardiger werd het, toen ik de volgende dag een schadebedrijf belde en de hersteller meldde: ‘Dit wordt een dure reparatie, want ik moet ook de parkeersensoren vervangen.’ Hoe wist hij van mijn parkeersensoren? Daar had ik niets over gezegd. Op die vraag antwoordde hij: ‘Meneer Nuijten, bij dit soort bumperschades is bijna altijd sprake van parkeersensoren.’

Ik realiseerde me dat ik in de loop der tijd steeds meer was gaan vertrouwen op mijn waarschuwingssysteem. Dat ik een gevoel van schijnveiligheid had ontwikkeld – alsof deze sensoren schade konden voorkomen (bijvoorbeeld door met een onzichtbare hand paaltjes te verzeen). Ik werd me ervan bewust dat ik daardoor doof was geworden voor de risicowaarschuwing die de sensor mij die avond had afgegeven. Een duur foutje, maar blijkbaar menselijk, want ik bleek niet de enige.

Niets meer missen?

Schrijf je dan in voor onze nieuwsbrief

Recent onderzoek in de schadesector laat zien dat auto’s met slimme hulpsystemen vaker schade rijden. IT die is bedacht om ons verkeersgedrag veiliger te maken, heeft een onbedoelde bijwerking: mensen voelen zich er veiliger door en gaan zich dan onveiliger gedragen. IT en menselijk risicogedrag hebben dus een ingewikkelde relatie met bedoelde en onbedoelde effecten.

In het vorige voorbeeld had IT nog een informerende en passieve rol in de auto. Maar steeds vaker krijgt IT daar een handelende en actieve rol: zij neemt dan feitelijk zowel de beslissingen als de acties van de bestuurder over. IT houdt uw positie op de rijbaan of de afstand tot de auto voor u in de gaten. IT grijpt in als ze het nodig vindt om te sturen of te remmen. Maar ook deze (bijna autonome) IT kan botsen met menselijk gedrag.

Politieauto’s

Een treffend voorbeeld zag ik enkele jaren geleden in de krant. De Nationale Politie meldde driehonderd nieuwe politieauto’s teruggehaald te hebben, vanwege IT die zij aan boord hadden. Deze auto’s hadden een remsysteem dat in de drukte van de stad zelfstandig en agressief remt, om aanrijdingen te voorkomen, en agenten klapten daarbij nogal eens met hun gezicht op het stuur of dashboard. Bij het achtervolgen en klemrijden van criminelen raakten ze bovendien in gevecht met hun overijverig remsysteem. Zo ontstond in de politieauto een soort machtsstrijd tussen agent en IT over wie de beslissingen mag nemen.

Zulke onverwachte fricties tussen bestuurder en IT lijken grappig, maar zijn dat allerminst als ze jezelf treffen. Zelfs de beperkte informatie over de problemen met de Boeing 737 MAX wijst al op een situatie zoals in de politieauto: een conflict tussen bestuurder en IT, met fatale gevolgen.

Deze voorbeelden laten zien dat IT en menselijk risicogedrag in ieder geval in het verkeer een ingewikkelde relatie hebben, die verdergaat dan alleen het gebruik van de smartphone achter het stuur. Mensen maken systematisch foutjes bij het verwerken van informatie, het inschatten van risico’s en bij beslissingen die ze bewust of onbewust nemen.

Die foutjes noemen we ‘biases’.

Informatietechnologie is ervoor bedoeld dat mensen over snellere en betere informatie beschikken, betere beslissingen nemen en dus ‘verstandiger’ omgaan met risico’s. Maar diezelfde IT blijkt juist nieuwe risico’s en beslissingsfoutjes uit te lokken. Dit roept dus de vraag op hoe wij betere beslissingen kunnen nemen met en over IT die we inzeen. En hoe wij vervelende verrassingen met diezelfde IT kunnen voorkomen. Heel kort gezegd is dat de essentie van mijn leerstoel ‘behavioral IT governance: naar betere IT-beslissingen met kennis van menselijk risicogedrag’. En dan niet in het verkeer, maar binnen organisaties.

Van auto naar werk

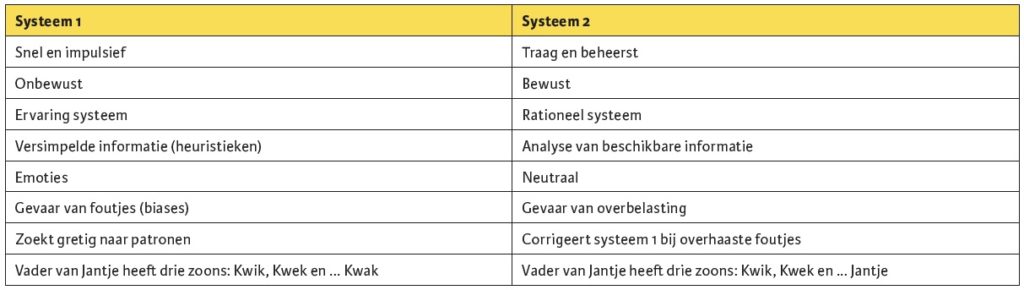

Hoe nemen mensen beslissingen? Voor ik inga op menselijke foutjes in IT-beslissingen, leg ik uit hoe wij beslissingen nemen. Ik gebruik daartoe het model van Stanovich en West (2000) dat door Nobelprijswinnaar Daniel Kahneman prachtig is beschreven in Thinking fast and slow. Het model beschrijft hoe ons brein informatie verwerkt en beslissingen neemt, waarbij onderscheid wordt gemaakt tussen een systeem 1 en een systeem 2 (zie tabel 1).

Zo leren we autorijden: in het begin moeizaam en denkend wegrijden, met bewust schakelen en in de spiegels kijken, op basis van systeem 2. Gaandeweg bouwen we ervaring op en rijden we onbewust op basis van de automatismen van systeem 1. Systeem 1 zorgt ervoor dat ons oog valt op wat belangrijk is in het drukke verkeer en het filtert informatie op basis van ervaringsregels. Die ervaringsregels kunnen ons echter ook voor de gek houden: je ziet namelijk wat je verwacht te zien en je ziet niet wat je niet verwacht.3 Als systeem 2 dan niet bij machte is om systeem 1 te corrigeren, leidt dit tot irrationele beslissingen – in het drukke verkeer of in de drukke wereld van IT-beslissingen.

IT-beslissingen

Het pallet aan IT-beslissingen is zo breed als de toepassing van IT binnen organisaties. Het gaat bijvoorbeeld over de strategische inzet van IT, de implementatie van een elektronisch patiëntendossier, het invoeren van slimme algoritmes of chatbots in een klantcontactcentrum of het veilig omgaan met klantgegevens. Bij al dergelijke IT-beslissingen liggen kansen en risico’s op de loer, waarbij de menselijke factor een rol speelt. Wij onderzoeken vooral complexe IT-projecten, omdat daarin vele aspecten aanwezig zijn. Een bestaande situatie (met alle ervaringen, vooroordelen en dus biases van dien), een gewenste situatie (die er nog niet is, waar alleen beelden van bestaan) en een vaak onstuimige reis van bestaande naar gewenste situatie. Ook zijn dergelijke IT-projecten vaak doorspekt met zowel belangen als beloften en met zowel rooskleurige vergezichten als mogelijk gezichtsverlies bij betrokkenen. Dit alles met IT die zich soms laat zien als oplossing en probleem tegelijk.

Informatietechnologie is de aanjager van wat de afgelopen jaren wel wordt omschreven als de VUCA-wereld (ofwel ‘velocity’, ‘uncertainty’, ‘complexity’ en ‘ambiguity’). Het lijkt wel of alles steeds hectischer wordt en sneller gaat. Wij worden gebombardeerd met informatie en toch moeten we verstandige beslissingen blijven nemen.

Velocity

Stel, u rijdt dagelijks naar uw werk en komt telkens langs dezelfde zijstraat. Het verkeer in die straat heeft voorrang. Er komt nooit iets uit. U kijkt daardoor nog amper en rijdt met steeds hogere snelheid deze straat voorbij, totdat het een keer misgaat. Doordat u er dagelijks in bevestigd wordt dat het goed gaat, wordt u compleet verrast als het misgaat. U zag het gevaar totaal niet aankomen. Zo zit ook uw IT vol met zijstraten waar onverwacht gevaar uit kan komen. In het begin bent u nog voorzichtig en bedachtzaam (systeem 2) bij het accepteren van cookies of andere ‘noodzakelijke’ stukjes software. Maar na verloop van tijd wordt u steeds lichtzinniger, het gaat immers altijd goed (systeem 1). Totdat het een keer faliekant misgaat, zoals blijkt uit de meeste beveiligingsincidenten.

Mensen zijn in zo’n situatie bovendien geneigd te schrikken en impulsief onhandige acties te nemen (systeem 1). Denk aan de caravanrijder die al vele uren 120 rijdt, wat goed gaat. Dan begint hij een klein beetje te slingeren, schrikt daarvan, stuurt tegen en belandt uiteindelijk heftig slingerend dwars op de snelweg, het asfalt bezaaid met de vakantie-inboedel.

In IT zijn dergelijke kleine inschattingsfouten en ongelukkige, impulsieve, menselijke reacties op een klein probleem, precies het patroon dat kwaadwillenden gebruiken om de IT-systemen van een organisatie te ontwrichten. We kennen de voorbeelden van organisaties die dachten dat de informatiebeveiliging op orde was. Totdat de caravan als het ware onverwacht ging slingeren en omsloeg en de IT-inboedel in een mum verspreid lag over de digitale snelweg. Waarbij men zich vertwijfeld afvraagt hoe het zover heeft kunnen komen. Kleine beslissingsfoutjes versterken zichzelf dus en kunnen zo in korte tijd een enorme impact krijgen.

Uncertainty

Het inschatten van risico’s in het verkeer maar ook van de informatietechnologie gaat per definitie gepaard met onzekerheden. Je weet immers niet zeker of een risico zich gaat manifesteren. In het verkeer heb je te weinig informatie, want je kunt niet van elke medeweggebruiker weten wat hij van plan is. Rationele beslissingen op basis van systeem 2 eisen dat wij inschattingen maken van kansen, impact en scenario’s. Zoals we hypotheken naast elkaar zeen en tot de meest verstandige keuze komen. Maar gedragseconomisch onderzoek laat zien dat mensen zelfs dán niet in staat zijn rationele keuzes te maken. Laat staan wanneer het risico’s betreft die niet uit te rekenen zijn en met een overweldigende hoeveelheid informatie (zoals in het verkeer of in de complexiteit van IT).

Complexity

U herinnert zich misschien de eerste keer dat u met de auto in de overweldigende drukte terechtkwam in het centrum van een grote stad als Parijs. Het lukte u niet te overzien waar het verkeer vandaan kwam. Uw rationele systeem met overzicht (systeem 2) werd namelijk verdrongen door angstbeelden van systeem 1 en u ging ineens fouten maken die u ‘normaliter’ niet zou maken.

In de wereld van IT is de massaliteit nog groter. IT ‘verbindt’ mensen, overbrugt afstanden en tijdsverschillen. Niet alleen mensen worden met elkaar verbonden; met slimme koelkasten, slimme meters en ‘radio-frequency identification’ ontstaat een reusachtig en krachtig netwerk waarbinnen de onderdelen elkaars gedrag ook nog eens beïnvloeden.

Tegelijkertijd kunnen risico’s zich binnen dit netwerk razendsnel verplaatsen en uitbreiden. In zo’n context moeten mensen daarom beslissingen nemen. Gevaren kunnen overal vandaan komen en het is onmogelijk om overzicht te houden. Kleine beslissingsfoutjes kunnen dan grote gevolgen hebben.

Ambiguity

Informatie en IT zijn vaak niet grijpbaar en laten ruimte voor interpretatie en ambiguïteit. Een stoplicht – als elementaire vorm van informatietechnologie – dat voor uw neus op oranje springt, betekent voor de ene persoon remmen en voor de andere gasgeven (systeem 1). Informatietechnologie kleurt dus letterlijk mee met de betekenis die de ontvanger van de informatie eraan toekent. Dit brengt risico’s mee als de automobilist vlak voor u besluit krachtig te remmen voor een oranje stoplicht en u zelf de impulsgedachte had om juist nog even flink gas te geven.

In organisaties zien we dit ook terug: bestuurders gebruiken stoplichtenrapportages en beslissen of ze zullen remmen of gasgeven bij een IT-project. Dit geeft heftige discussies of een project groen, oranje of rood gerapporteerd moeten worden – oranje is daarbij overigens een nogal ruim begrip. En het kan nog ingewikkelder, zoals bij het fenomeen watermeloenprojecten; een bekend begrip bij IT-projecten bij de overheid. Dit zijn projecten die groen van buiten zijn, maar rood van binnen. IT maakt dus veel mogelijk, maar schept ook onduidelijkheid als we er beslissingen over moeten nemen. Ambiguïteit is een voedingsbodem voor biases en dus voor ongelukken.

Voorbeelden van IT-beslissingen die fout gaan

In het ‘drukke verkeer’ van de IT-beslissingen moeten we proberen verstandige beslissingen te nemen (met systeem 2), maar gaan biases uit systeem 1 met onze beslissingen aan de haal. Een fenomeen dat wij daarom intensief onderzoeken, zijn complexe ITtprojecten die ‘op hol slaan’ en nauwelijks meer gestopt of bijgestuurd kunnen worden.

Van de IT-projecten lijdt 30-40 procent aan een dergelijk probleem en het lukt ons amper om daar verstandige beslissingen over te nemen. Zo is er het ‘near-completion effect’ met projecten die volgens rapportages voor 90 procent gereed zijn, zodat we ermee door gaan; we zijn er immer bijna. Totdat we er hardhandig achterkomen dat het project niet eens levensvatbaar is, laat staan voor 90 procent klaar. We hebben ons laten verblinden door de 90 procent uit systeem 1.

En zo laten we ons ook verblinden door het zogenoemde ‘sunk cost effect’: projecten die we niet meer kunnen stoppen of bijsturen, omdat er al zoveel geld aan uitgegeven is en men vervolgens gaat gokken (casinogedrag). Het is helaas de realiteit van grote IT-projecten (en andere complexe projecten): ze zijn te complex voor systeem 2. Systeem 1 stuurt onze beslissingen namelijk met versimpelde informatie en kan ons daarbij voor de gek houden. En dit probleem is niet zomaar weg door over te stappen op een andere methode (zoals Agile).

Uit onderzoek naar incidenten met informatieveiligheid blijkt dat de menselijke factor vaak een rol speelt. Een hoog niveau van veiligheidsmaatregelen maakt immers dat mensen zich veiliger gaan voelen. Zeker als ze de ervaring hebben dat het altijd goed gaat, gaan zij zich onveiliger gedragen. Zo overkomt het ervaren IT-professionals dat ze beveiligingspatches op de plank laten liggen, totdat het ineens goed fout gaat. Dat is dus geen gebrek aan deskundigheid, maar een ongepast gevoel van veiligheid; schijnveiligheid.

Naar analogie van het verkeer noemen wij dit de gordelparadox, omdat mensen na de invoering van de autogordels harder en onvoorzichtiger gingen rijden. Veilig gedrag zou misschien gestimuleerd kunnen worden door veiligheidsmaatregelen eens weg te nemen, zodat mensen ze minder vanzelfsprekend gaan vinden.

Concluderend: onder invloed van IT wordt de context waarbinnen wij beslissingen moeten nemen dynamischer, onzekerder, complexer en meer ambigu (VUCA). Dit stelt onze hersencapaciteit enorm op de proef bij het nemen van beslissingen.4 In dergelijke situaties is systeem 2 niet in staat om alle informatie te verwerken, dus voert systeem 1 (met zijn biases) de boventoon in onze beslissingen.

Waarom behavioral IT governance?

Gangbare opvattingen

Toen IT ongeveer 25 jaar geleden in veel organisaties steeds belangrijker werd, ontstond de term IT-governance. Governance komt van het Griekse werkwoord ‘kubernáo’, wat sturen betekent. IT-governance gaat dus over het sturen van IT in een organisatie. Het beschrijft hoe je rollen en processen kunt inrichten om IT tot zijn recht te laten komen en de risico’s van IT kunt beheersen. Er zijn vele definities, maar de essentie is dat je met IT-governance betere IT beslissingen neemt en dat de niet IT-professionals in de omgeving (zoals commissarissen en toezichthouders) er gerust op kunnen zijn dat de organisatie verantwoord met IT-risico’s omgaat (Web, Pollard & Ridley, 2006).

De invulling van IT-governance is over de jaren heen in hoge mate gekleurd door IT-professionals. IT-beslissingen werden in een model gezet. We beschreven doelen en -subdoelen, met processen en subprocessen, we beschreven rollen en controles om IT-risico’s te meten en te signaleren. Deze manier van denken en oplossen heeft veel goeds gebracht, want zij heeft de IT-beslissingen in veel organisaties enorm verbeterd.

Tegelijkertijd voelt het voor mij echter ongemakkelijk om IT-beslissingen op zo’n bijna wiskundige manier te modelleren en organiseren. Het is deterministisch ofwel het gaat ervan uit dat wij onze IT-beslissingen laten leiden door doelstellingen die we met elkaar afspreken. En het is reductionistisch, omdat we grote IT-beslissingen opdelen in kleinere IT-beslissingen en die weer in nóg kleinere IT-beslissingen. Als we al die kleine beslissingen dan weer optellen tot grote beslissingen, dan beheersen we onze IT-risico’s. Met ‘maturity-levels’ stellen we dan vast dat we IT-risico’s in hoge mate onder controle hebben. Daar verschaffen wij anderen zekerheid over.

En hier zit precies het ongemak van de parkeersensoren uit mijn introductie: het gevaar van schijnzekerheid. De technische, modelmatige oplossingen bedacht door IT-professionals veronderstellen rationeel (systeem 2-)gedrag van mensen. De notie van begrensde rationaliteit en menselijke risicogedrag is als het ware weggeschreven uit ons technische en procedurele denken over IT-governance. En dat is niet vreemd, want het is ook niet het traditionele vakgebied van IT-professionals.

Maar datzelfde irrationele menselijk gedrag verklaart misschien wel waarom zoveel organisaties onaangenaam wakkerschrikken door IT-gebeurtenissen die ik voorzichtig maar even parkeerschades noem, maar die misschien meer lijken op het voorbeeld van de caravan op de snelweg, waarbij we ons achteraf verbaasd afvragen hoe het zover heeft kunnen komen. Waarom IT-projecten die voor 90 procent klaar leken, ineens veranderen in een nachtmerrie en waarom organisaties met de hoogste maturity-levels in hun IT ook soms ongenadig hard onderuit kunnen gaan. Het is volgens mij nog maar de vraag of meer IT-modellen en meer IT-deskundigheid ons daarbij gaan helpen.

Wat voegt behavioral IT governance daaraan toe?

Met mijn leerstoel neem ik de inzichten uit gedragseconomie en psychologie over menselijke foutjes in beslissingen en risicogedrag als uitgangspunt. En die onderzoek ik in de context van IT, want juist de VUCA-kenmerken van IT werken foutjes in de hand die we nooit zouden begrijpen als we IT en risicogedrag los van elkaar zouden bestuderen. Het verhaal zit juist in de combinatie van die twee.

Het onderzoek van de leerstoel is erop gericht om met kennis van risicogedrag bij te dragen aan betere IT-beslissingen. Wetende dat biases nu eenmaal onderdeel uitmaken van onze menselijke manier van beslissingen nemen, zoeken we met een multidisciplinair team van onderzoekers naar oplossingen volgens een drietal onderzoekslijnen:

- biases ontdekken,

- biases voorkomen of corrigeren,

- biases benuen.

Oplossingsgericht onderzoek naar behavioral IT governance

Biases (eerder) ontdekken

Samen met Nick Benschop, Cokky Hilhorst en Mark Keil heb ik afgelopen jaren onderzoek mogen verrichten naar complexe IT-projecten bij de overheid. Wij zijn op zoek gegaan naar de verborgen informatie in businesscases van IT-projecten die iets kan vertellen over de manier waarop beslissingen worden genomen (Benschop, Hilhorst, Nuijten & Keil, 2020). Wij onderzochten specifiek taalgebruik die een voorbode kan zijn van een bekende bias bij dergelijke projecten: ‘planning fallacy’, waarbij mensen geneigd zijn tot veel te optimistische inschattingen.

Wij constateerden, in lijn met theorie over biases, dat mensen bijvoeglijke naamwoorden gebruiken die een hoge mate van detail suggereren – alsof we alles weten en kunnen optellen – en dat dit verband hield met tegenvallers en overschrijdingen die later optraden in dit project. Businesscases met woordgebruik dat iets meer afstand van de details liet zien, en dus iets meer overzicht, bleken minder overschrijdingen en tegenvallers te vertonen.

Dit is natuurlijk geen oorzaak en gevolg, maar een dergelijke analyse van taalgebruik geeft ons wel inzicht in de onbewuste processen bij mensen die inschattingen maken en de biases die daarbij optreden. Dit bij de mensen die het document opstellen en onbewust dus ook bij de mensen die belangrijke beslissingen nemen, zoals het al dan niet starten van een IT-project. Deze onderzoekslijn trekken wij komende jaren door met a) onderzoek naar taalgebruik gedurende het project, en b) meer geavanceerde vormen van tekstanalyse.

Biases voorkomen of corrigeren

In het kader van IT-governance voegen we meestal extra rollen toe aan de organisatie, vaak met mensen in controlerende en signalerende functies. Wij onderzoeken of en hoe dat leidt tot betere IT-beslissingen. Gestart met een afstudeeronderzoek met Bert Zwiers hebben wij een aantal jaren geleden data verzameld over de inschttaing van IT-risico’s binnen een organisatie, op basis van een aantal cases waarbij de kans en impact varieerden. Later hebben we dat onderzoek uitgebreid met interviews en constateerden wij dat er sprake is van een ‘actor-observer effect’ (Nuijten, Keil, Van de Pijl & Commandeur, 2018). Vergelijk het met de situatie in de auto. Op de bijrijderstoel schat u de risico’s in het verkeer hoger in dan wanneer u zelf het stuur in handen heeft.

Als het slecht gaat met een IT-project, zie je vaak de reflex om extra controlerende rollen en dus ogen toe te voegen. Met buitenpromovendus Jean-Pierre Thöni onderzoeken wij of het toevoegen van rollen – ook wel ‘lines of defense’ genoemd – ook daadwerkelijk leidt tot een betere risicosignalering in organisaties (Thöni, 2019). In een praktijkexperiment onderzoeken wij of er misschien een zogenaamd ‘bystander-effect’ optreedt dat averechts uitpakt. Met andere woorden: als er meer passagiers in de auto zitten, zijn die dan ook meer geneigd om de chauffeur aan te spreken, dan wanneer er maar één passagier in de auto zit? Of zijn zij dan geneigd hun mond te houden – in literatuur wordt dit ‘mum-effect’ genoemd – vanuit de gedachte: ‘Iemand anders kan ook zijn mond opendoen, waarom moet ik dat per se zijn?’ Onderzoek naar het ‘mum-effect’ in organisaties is relevant, zeker bij grotere IT-projecten.

Maar stel dat iemand zijn of haar mond opendoet en een risicowaarschuwing afgeeft aan de bestuurder, wat maakt dan dat een bestuurder geneigd is daarnaar te luisteren? In een reeks experimenten onderzochten wij het zogenoemde ‘deaf effect’ in de context van grote IT-projecten. Je kunt in een organisatie uiteraard definiëren welke rollen er zijn, maar uit ons experiment blijkt dat het voor effectieve IT-governance van belang is hoe rollen elkaar zien. Wij hebben in een experiment vastgesteld dat managers eerder luisteren naar een risicowaarschuwing als ze de boodschapper als partner zien en niet als tegenstander (Nuijten, Keil & Commandeur, 2016). Weer terug naar de auto: als de bestuurder het beeld heeft dat de bijrijder hem op fouten wijst en de bijrijder als tegenstander ziet, dan werkt zo’n waarschuwing averechts.

Maar ook de manier waarop de boodschap wordt gegeven heeft invloed op de mate waarin een organisatie geneigd is te luisteren. In een experiment hebben we vastgesteld dat het negatief formuleren van een risicoboodschap (in termen van verlies) ertoe leidde dat mensen juist risico’s gingen nemen en de boodschap in de wind sloegen.5 Dus als u als bijrijder een risicowaarschuwing afgeeft en daarin vooral de verlieskant belicht, dan kunt u bedrogen uitkomen; de bestuurder zal dan juist geneigd zijn uw risicowaarschuwing in de wind te slaan.

Deze onderzoekslijn trekken wij komende jaren door met onderzoek naar de interactie tussen rollen in de organisatie, in het bijzonder naar a) groepsbeslissingen en sociaal risicogedrag, en b) factoren die het ‘deaf effect’ beïnvloeden. In het bijzonder volgen we (met Leon Yap) een lijn met experimenten gebaseerd op muziektheorieën. Ook gaan we intensiever gebruikmaken van ‘system dynamics modeling’.

Biases benutten

Door gebruik te maken van de kennis van biases kun je met zogenoemde ‘nudges’ mensen een duwtje geven, zodat zij onbewust geneigd zullen zijn het gewenste risicogedrag te vertonen. Een bekend voorbeeld van zo’n ‘nudge’ zijn de Holle Bolle Gijs-prullenbakken in De Efteling die mensen onbewust moeten verleiden om gewenst gedrag te vertonen. Met ‘nudges’ maak je het gewenste risicogedrag makkelijker, aantrekkelijker, socialer of beter getimed. En door een spelelement toe te voegen (dit heet ‘gamification’) kan het gedrag ook over een langere periode beïnvloed worden.

o ontwikkelde Interpolis een game voor op de smartphone om het gebruik ervan achter het stuur tegen te gaan, precies gebruikmakend van dezelfde biases die het probleem veroorzaken. En Tesla maakt er een spel van om de informatieveiligheid van de auto te kraken en daarmee te verbeteren.

Net zoals u uw hardloopprestaties verbetert door uw resultaten te delen met andere lopers en elkaar – met een sociale norm – vooruithelpt om gezondheidsrisico’s te verminderen. Daarbij wordt juist weer de kracht van IT benut om op een slimmere manier om te gaan met risicogedrag.

In een eerste studie heb ik samen met Mark van Twist verkend hoe ‘gamification’ kan worden ingezet om de informatieveiligheid in een ziekenhuis te verbeteren (Nuijten & Van Twist, 2018). Dit gaat nog veel experimenteel onderzoek vragen, want uit een experiment van de bij ons gepromoveerde Violeta Verbraak bleek dat ‘nudgen’ met een sociale norm soms goed werkt, maar soms juist averechts uitpakt voor risicogedrag in IT-projecten (Verbraak, Nuijten & Keil, 2015). Deze onderzoekslijn zal in de komende tijd worden voortgezet in de vorm van gedragseconomische veldexperimenten, die wij hopelijk met en bij overheden en bedrijven kunnen uitvoeren.

Tot besluit

Ik hoop met mijn betoog te hebben overgebracht dat mijn onderzoeksterrein interessant is en iets toevoegt aan wat er al was. Afsluitend wil ik nog even van een afstandje naar mijn leerstoel kijken. Ten eerste: het onderzoeksthema van mijn leerstoel is niet nieuw. Ik heb een notitie (typemachine) bewaard van een lezing over informatiebeveiliging die Willem Wagenaar in 1988 hield bij de Rabobank, waarin hij uitlegt dat zelfs experts zich niet altijd rationeel gedragen. Hij vertelt ook over beslissingsfoutjes en schijnzekerheden en noemt oplossingen die vandaag de dag bekend staan als ‘nudges’ (zoals de kunstmatige vlieg in de toiletpot).

Het is dus geen onderwerp dat pas werd bedacht bij de introductie van de mobiele telefoon in de auto. En het waait ook niet zomaar over als we straks IT-beslissingen laten nemen door algoritmes en kunstmatige intelligentie. Dergelijke technische oplossingen ‘leren’ van onze taal en ze kopiëren onze biases. Daarmee verdwijnen deze biases onder de motorkap van IT; uit het zicht, maar niet minder gevaarlijk. Ook methodische oplossingen van IT-professionals (zoals Agile) wakkeren in mijn ogen weer nieuwe schijnzekerheid en biases aan. De VUCA-wereld gaat niet zomaar weg, dus mijn onderzoeksthema blijft voorlopig nog wel actueel.

Ten tweede: als je je – net als ik – geroepen voelt om onderzoek naar biases in organisaties te doen, mag je niet weglopen voor biases in je eigen onderzoek. Er ligt inderdaad een belangrijke bias op de loer: het beeld (systeem 1) dat IT-projecten per definitie mislopen, dat ‘managers’ doof of blind zijn voor waarschuwingen en dat IT dus allemaal kommer en kwel is. Als je dat namelijk gelooft, dan zie je wat er bij dat beeld past en zie je ook niet wat er níet bij past – je krijgt vanzelf gelijk, je angstbeeld komt uit.

Juist daarom kiezen wij een ander, meer hoopvol en positief perspectief in ons onderzoek. ‘Gamification’ om onbewust betere beslissingen te nemen. Taalgebruik, niet alleen om vast te stellen dat het misgaat, maar ook als perspectief om (onbewust) te verbeteren. We hanteren concepten uit muziektheorie, want dezelfde mensen die in hun IT-project niet luisteren naar een belangrijke boodschap, stappen in de auto en zeen muziek op (ongevraagd en onbewust). Wat kunnen we daarvan leren, als we een boodschap willen overbrengen? En de smartphone is niet alleen de oorzaak van slingergedrag in het verkeer of dat iemand per ongeluk een afslag mist. Als u namelijk hardop zegt waar u heen wilt, dan helpt diezelfde IT dat u de goede afslagen neemt en u op uw bestemming aankomt; zij loodst u bovendien langs de files. We vinden dit nu al zo vanzelfsprekend, dat we het niet meer zien en alleen oog hebben voor de problémen van IT. In mijn onderzoek moet ik dus alert blijven dat ik niet zelf in de valkuilen trap die we onderzoeken.

Ten slotte: in mijn drive om IT en menselijk risicogedrag in combinatie te onderzoeken, sta ik niet alleen. Onderzoeker en schrijver Marcel Canoy deed twee jaar lang participerend onderzoek naar cultuur en risicogedrag bij de Rabobank, op alle niveaus in de organisatie, in binnen- en buitenland. Hij schreef daarover een lezenswaardig boek: De bank van goede bedoelingen (2019). Volgens hem staat IT in de schijnwerpers, evenals menselijk risicogedrag, maar dat juist de combinatie daarvan onderbelicht blijft in governance en bij controles. En dat juist daar subtiele, verborgen gevaren zi en die een enorme impact kunnen hebben. Canoy concludeert in zijn boek: ‘De banken zouden er daarom goed aan doen als ze vol inze en op gedragseconomische experimenten die een oplossing kunnen bieden, (…) zodat digitalisering niet een vloek maar een zegen wordt.’

Praktijkgericht wetenschappelijk onderzoek dus. Dat is precies wat wij afgelopen jaren gedaan hebben en ook de komende jaren zullen doen, hopelijk in nauwe samenwerking met overheden en bedrijven die dit onderwerp ook de moeite waard vinden. Onderzoek van ‘samen’ dus.

Door: Arno Nuijten

Prof. dr. A. Nuijten is bijzonder hoogleraar behavioral IT governance aan de Open Universiteit en als wetenschappelijk directeur verbonden aan het expertisecentrum Behavioral Risk van de Erasmus School of Accounting & Assurance te Rotterdam.

Bron: Tijdschrift M&O