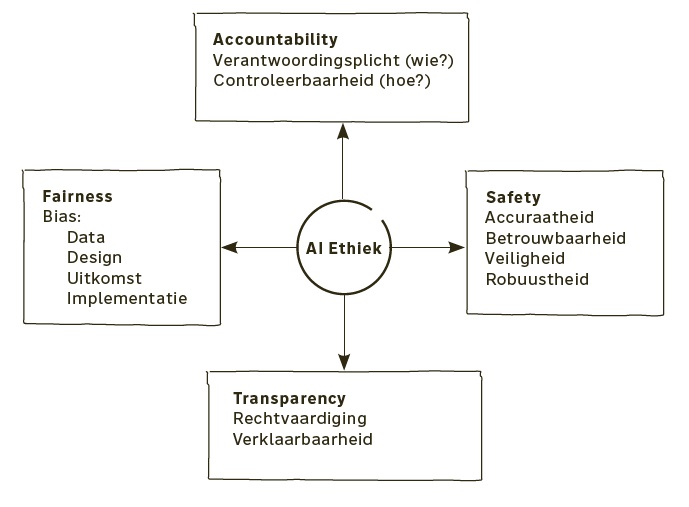

Het gebruik van AI in bedrijven, publieke organisaties en binnen overheden houdt altijd risico’s in. Daarom worden steeds vaker de FAST-principes gebruikt. FAST staat daarbij voor fairness, accountability, safety en transparency.

Geschatte leestijd: 8 minuten

Inhoudsopgave

AI ondoorzichtig

AI wordt soms op een manier gebruikt die niet voor iedereen even eerlijk is of die ondoorzichtig is, waardoor je

niet kunt controleren wat er nu precies gebeurt in zo’n AI-systeem. Een bekend voorbeeld is het Gender Shades-project van het MIT Media Lab en Microsoft Research, waaruit bleek dat veel AI voor gezichtsherkenning de gezichten van mannen veel beter herkende dan die van vrouwen. Ook gold: hoe donkerder je huid, hoe slechter de gezichtsherkenning scoort.

Vaak bedoelen organisaties het niet slecht, maar sluipen bias en nontransparantie ongemerkt een systeem in. AI-systemen zijn gebouwd op data, en die data komen uit het verleden. Dat betekent dat alle historische

vooroordelen in onze samenleving opborrelen wanneer we zo’n systeem gebruiken om onze toekomst te voorspellen en vorm te geven.

Dat kan negatieve gevolgen hebben voor de echte wereld, voor mensen die een baan niet krijgen of een slechte beoordeling krijgen die ze niet verdienen. Geen enkele manager wil dat het AI-systeem van zijn organisatie negatieve krantenkoppen haalt. Het is dus de moeite waard om vooruit te denken om mogelijke problemen te vermijden.

Ethische bedreigingen

Ethische bedreigingen die hierbij een grote rol spelen, zijn onder meer bias of vooringenomenheid, het probleem van opacity of ondoorzichtigheid en de mogelijkheid van discriminatie. En dit soort bedreigingen

zijn met elkaar verbonden. Vooringenomenheid kan schuilen in complexe modellen, met discriminatie tot gevolg. In plaats daarvan willen we dat onze AI-systemen fair of eerlijk en verklaarbaar zijn en op een goede manier met gegevens omgaan. Laten we eens wat meer nadenken over de eerste twee kwesties.

Allereerst is het belangrijk om je te realiseren dat algoritmen niet neutraal zijn. Algoritmen zijn meningen die in code zijn ingebed. Vergelijk het eens met koken. Een recept is eigenlijk een soort algoritme. Het doel

is om een maaltijd samen te stellen. De ingrediënten en de hoeveelheden die je nodig hebt van elk ingrediënt, zijn daarbij de parameters en gewichten van een model. Een belangrijk aspect bij het schrijven van zo’n recept is het definiëren van succes: wanneer is een maaltijd geslaagd?

Misschien geef je veel om smaak: je recept moet dan veel vet, zout en suiker bevatten. Anderen vinden wellicht hun gezondheid belangrijk en stoppen vooral veel voedingsstoffen in hun recept, terwijl het weinig vet, zout en suiker bevat. Zo’n definitie van succes bevat daarom ook altijd meningen én vooroordelen. Dat geldt ook voor de definitie van succes in een algoritme. Het is belangrijk hier rekening mee te houden: een rekruteringsalgoritme kan worden geoptimaliseerd om werknemers te selecteren die het meeste geld voor een bedrijf verdienen, maar dit gaat ten koste van teamwerk of moreel gedrag. Een organisatie moet goed nadenken over deze afwegingen. Onthoud daarom dat AI geen volledig neutrale beslissing kan geven.

Ondoorzichtig AI

Een tweede, en aanverwant probleem is ondoorzichtigheid. Je hebt vast weleens de term ‘blackboxalgoritmen’ gehoord. Meestal verwijst dit naar complexe modellen zoals neurale netwerken of deep-learningalgoritmen,

die zichzelf versterken en moeilijk te controleren zijn omdat ze zo veel berekeningen bevatten. Maar ondoorzichtigheid – het probleem dat je niet begrijpt wat AI van plan is – kan ook van toepassing zijn op veel eenvoudigere algoritmen.

Dat komt bijvoorbeeld doordat de technische geletterdheid onder de bevolking vrij laag is. Maar er zijn meer bronnen van ondoorzichtigheid als het gaat om AI, niet alleen complexiteit. Soms willen bedrijven niet dat iemand hun algoritme begrijpt; een algoritme kan een belangrijke bron van concurrentievoordeel zijn. Geheimhouding kan ook ‘gamen’ van een algoritme voorkomen. Als sollicitanten weten naar welke trefwoorden een algoritme in een cv zoekt, kunnen ze deze woorden gewoon in het document plaatsen om geselecteerd te worden. Ook redeneren mensen en machines anders: het is bijvoorbeeld moeilijk voor een AI-systeem om uit te leggen waarom het denkt dat het naar een kat kijkt, terwijl een mens dat moeiteloos kan uitleggen.

Een laatste bron van ondoorzichtigheid is wat ik de leveranciershype noem: bedrijven verkopen soms nep-AI. Bijvoorbeeld door te beweren dat ze een nieuwe geavanceerde chatbot hebben, maar deze feitelijk wordt aangedreven door mensen. Soms wordt een mediarage strategisch gebruikt om te verbergen wat er achter de schermen gebeurt.

FAST-principes

Hoe open je die zwarte doos van AI, om ervoor te zorgen dat je alleen eerlijke, verklaarbare en transparante AI-systemen gebruikt? Het is natuurlijk allereerst belangrijk dat je ervoor zorgt dat je op de hoogte bent

en blijft van de ontwikkelingen. Volg opleidingen om te snappen wat de techneuten bedoelen, en volg je instinct. Daarnaast wordt er door allerlei organisaties geïnvesteerd in protocollen en standaarden voor

eerlijk, verantwoord en transparant gebruik van AI. Daarvoor worden veelal de zogenoemde FAST-principes gebruikt. FAST staat daarbij voor fairness, accountability, safety en transparency.

Fairness

Fairness: AI moet eerlijk zijn. Het Gender Shades-project, dat ik hiervoor al noemde, liet een aantal duidelijke voorbeelden zien van AI-toepassingen die niet eerlijk zijn omdat ze mannen beter herkennen dan vrouwen. Stel je voor dat een job-interviewagent die gebruikt wordt voor een eerste selectie in een sollicitatieronde mannen bevoordeelt, simpelweg omdat het beeldherkenningsalgoritme hen beter herkent dan vrouwen; dat zou een typisch geval van een oneerlijke AI-toepassing zijn. Het is belangrijk om te erkennen dat AI-systemen zijn ontworpen door mensen, die de beperkingen van hun context en vooroordelen kunnen inbrengen in de systemen. Er kan bijvoorbeeld bias optreden bij het verzamelen en annoteren van gegevens. Het is cruciaal om ervoor te zorgen dat trainings- en testdatasets representatief genoeg zijn (inclusief data van verschillende bevolkingsgroepen en minderheden) om fouten en discriminatie te voorkomen. Tijdens de implementatie van zo’n systeem is het ook belangrijk om ervoor te zorgen dat het wordt ingezet door gebruikers die zijn opgeleid om ze op een verantwoorde en onbevooroordeelde manier toe te passen.

Accountability

Accountability: verantwoord gebruik van AI. Het principe van accountability of verantwoordelijkheid vereist dat de verantwoordelijkheid voor AI-beslissingen ligt bij de menselijke ontwikkelaars en de gebruikers die de systemen in de praktijk toepassen. Het gaat dan eigenlijk over twee aspecten. De verantwoordingsplicht, die

iets zegt over wie verantwoordelijk is voor een uitkomst van zo’n systeem. En controleerbaarheid, dat inspeelt op hoe ontwikkelaars en gebruikers verantwoordelijk moeten worden gehouden. Als een AI-systeem een antwoord geeft, moeten de verantwoordelijken kunnen uitleggen hoe dit antwoord tot stand is gekomen. Het is van cruciaal belang om de verantwoordelijkheid in alle stadia te bewaken, van systeemontwikkeling tot het moment waarop het systeem wordt toegepast in de praktijk en tot wanneer het uiteindelijk niet langer gebruikt wordt en verwijderd wordt. Een goed voorbeeld van accountability is hoe in het geval van de MONOcam van de Nationale Politie een verbalisant, nadat het systeem een overtreding heeft geconstateerd, altijd nog beoordeelt of die constatering terecht is. De verbalisant kan hierdoor uiteindelijk worden aangesproken

op een bekeuring en is verantwoordelijk voor het uiteindelijke besluit dat genomen wordt.

Safety

Safety: betrouwbaarheid en veiligheid. Het veiligheidsprincipe vereist dat, afhankelijk van de praktische setting, een AI-toepassing nauwkeurig is en binnen een verwacht foutenpercentage werkt. Een AI-systeem moet betrouwbaar zijn om consistente resultaten te genereren. Het moet veilig zijn en daardoor de privacy en vertrouwelijkheid van gegevens die gebruikt worden waarborgen. En een AI-systeem moet robuust zijn, om zelfs bij onverwachte veranderingen en verstoringen de bediening te garanderen. Een goed voorbeeld van zo’n robuust systeem is een vakkenvulrobot in een supermarkt. Een robot die getraind is om meloenen netjes te stapelen moet vanzelfsprekend het verschil zien tussen een meloen en het hoofd van een net langslopend kind. En dat is ook een belangrijke reden waarom we dit soort AI-toepassingen de komende jaren waarschijnlijk nog niet gaan zien gedurende de openingstijden van supermarkten: in verband met de veiligheid verwachten specialisten dat dergelijke activiteiten vooral ’s nachts zullen worden uitgevoerd.

Transparency

Transparency: betrouwbaarheid en validatie. Het laatste FAST-principe is transparantie. Beperkte transparantie kan de betrouwbaarheid van AI-systemen verminderen en de validatie van de resultaten en de identificatie van fouten en vooroordelen belemmeren. Stel je eens voor dat een AI-toepassing om vroegtijdig tuberculose te kunnen ontdekken aan de hand van röntgenfoto’s niet transparant is, waardoor medisch specialisten niet kunnen controleren of een diagnose ook echt op een juiste manier wordt vastgesteld. Daarom is het noodzakelijk om alle gevolgde processen tijdens het ontwerp en het gebruik van een AI-systeem te kunnen beoordelen. Het moet mogelijk zijn om de basisgedachte achter de beslissingen of het gedrag van een systeem te begrijpen. Er wordt in relatie tot transparantie ook wel gesproken over explainable AI of verklaarbare AI. Het doel van explainable AI is om AI-beslissingen transparanter en betrouwbaarder te maken.

Bron: AI in de praktijk

Door: Hennie Huijgens